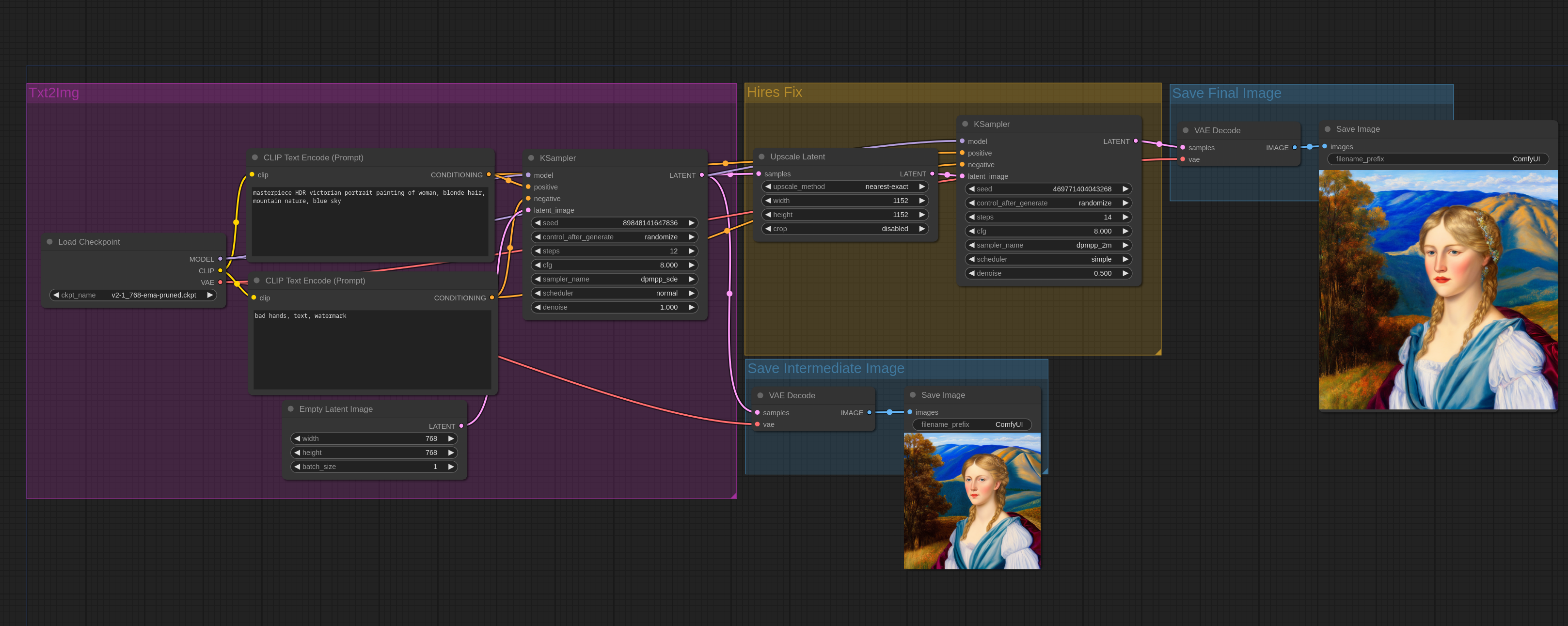

这些示例演示了如何实现“Hires Fix”功能。

您可以在ComfyUI中加载这些图像以获得完整的工作流程。

Hires 修复只是创建一个分辨率较低的图像,将其放大,然后通过 img2img 发送。请注意,在 ComfyUI 中,txt2img 和 img2img 是同一个节点。Txt2Img 是通过将空图像传递给具有最大去噪效果的采样器节点来实现的。

以下是 ComfyUI 中通过基本潜在升级执行此操作的简单工作流程:

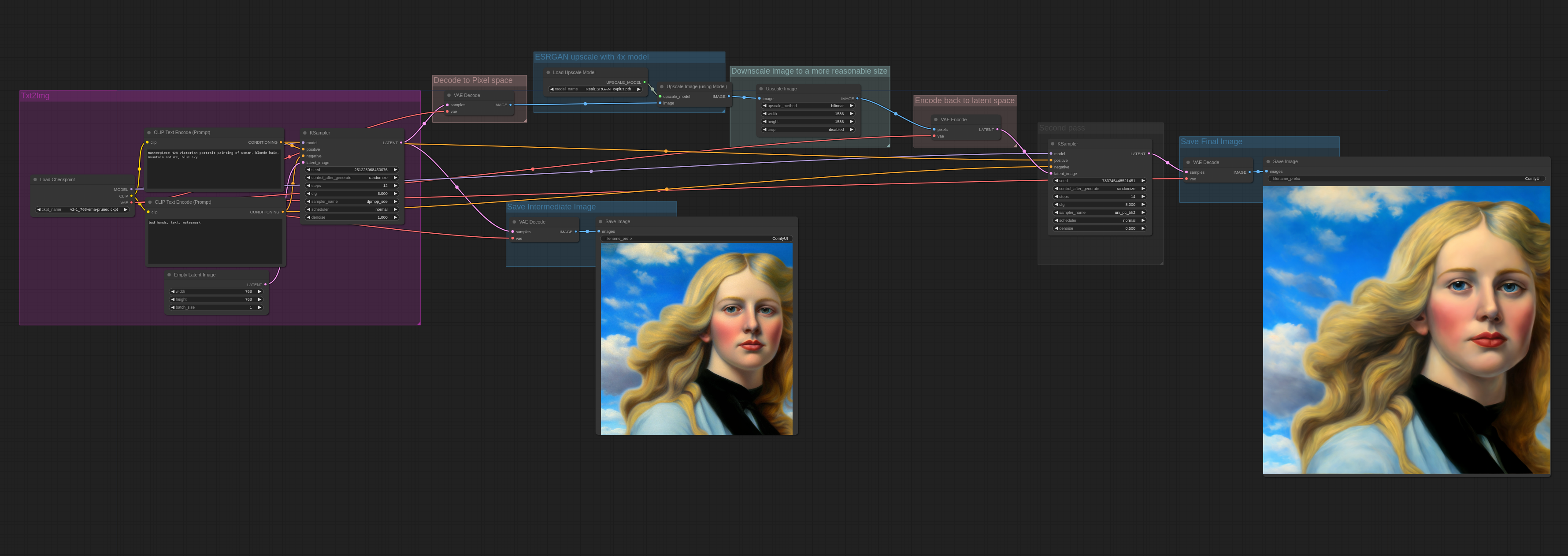

非潜在升级

以下是如何使用esrgan 升级器进行升级步骤的示例。由于 ESRGAN 在像素空间中运行,因此图像在升级后必须转换为像素空间并转换回潜在空间。

更多示例

下面是一个更复杂的 2 次传递工作流程的示例,该图像首先使用 WD1.5 beta 3 幻觉模型生成,进行潜在升级,然后使用 cardosAnime_v10 进行第二遍传递:

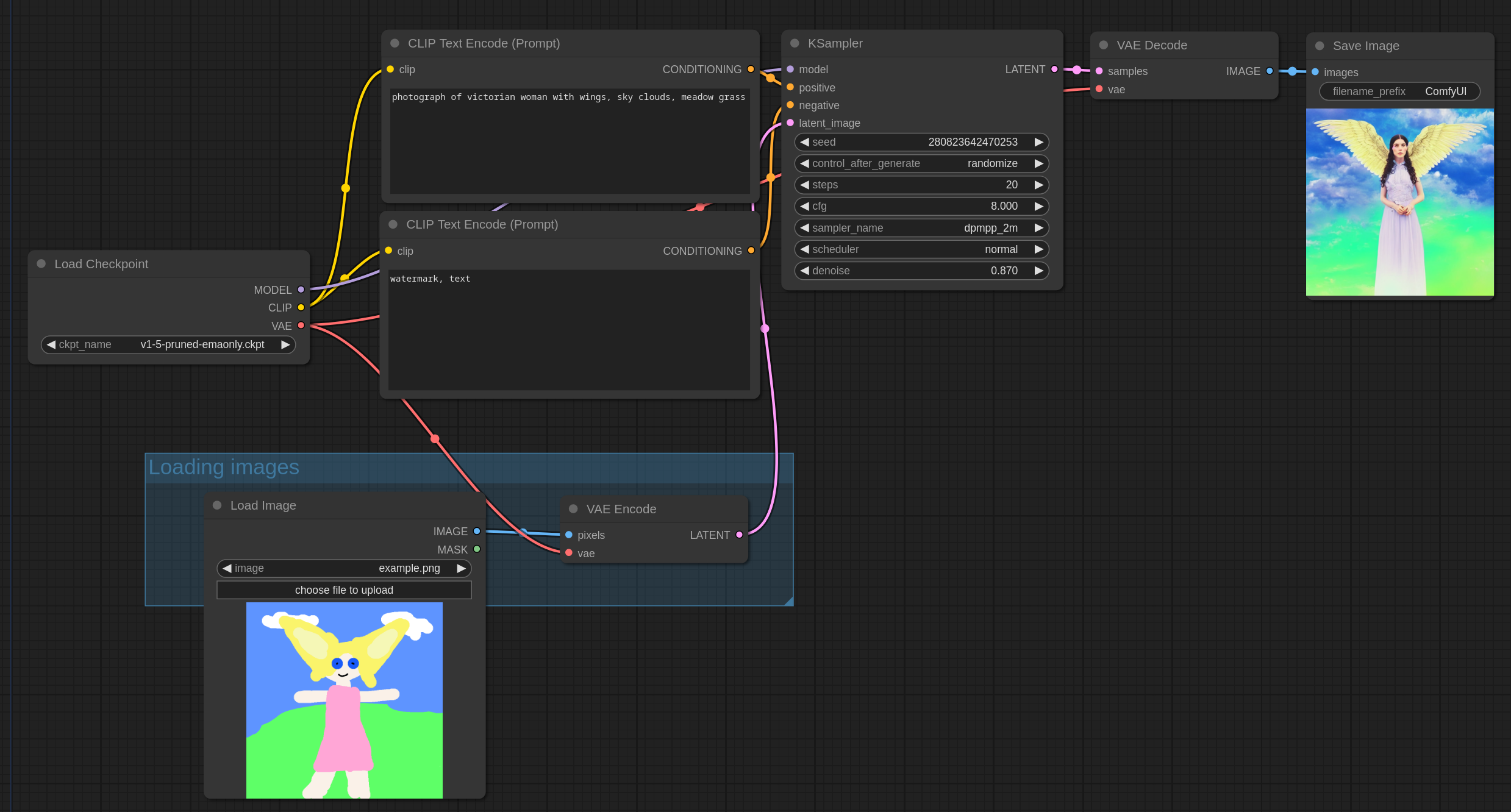

这些是演示如何执行 img2img 的示例。

您可以在ComfyUI中加载这些图像以获得完整的工作流程。

Img2Img 的工作原理是加载一张类似此示例图像的图像,使用 VAE 将其转换为潜在空间,然后使用低于 1.0 的降噪对其进行采样。降噪控制添加到图像中的噪声量。降噪越低,添加的噪声越少,图像变化越小。

输入图像应放在输入文件夹中。

这是一个简单的 img2img 工作流程,它与默认的 txt2img 工作流程相同,但去噪设置为 0.87,并且将加载的图像而不是空图像传递给采样器。

在此示例中,我们将使用此图像。下载它并将其放在您的输入文件夹中。

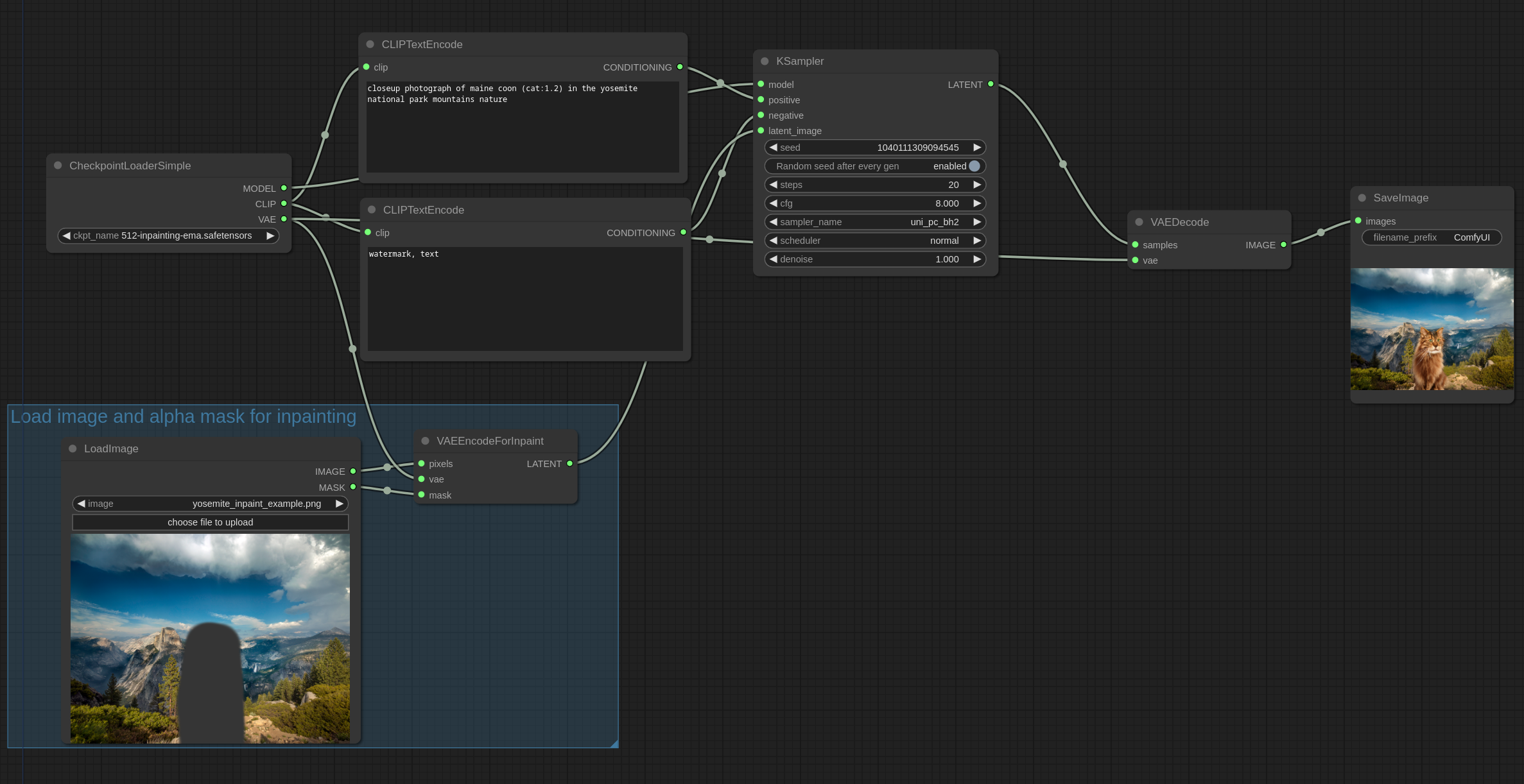

此图像的一部分已使用 gimp 擦除为 alpha,alpha 通道是我们将用作修复的蒙版。如果使用 GIMP,请确保保存透明像素的值以获得最佳效果。

ComfyUI 还具有一个掩码编辑器,可以通过右键单击 LoadImage 节点中的图像并“在 MaskEditor 中打开”来访问。

可以在ComfyUI中加载以下图像以获取完整的工作流程。

使用 v2 修复模型修复一只猫:

使用 v2 修复模型修复女性图像:

它也适用于非修复模型。以下是使用 anythingV3 模型的示例:

超越绘画

您还可以使用类似的工作流程进行外画。外画与内画是一回事。有一个“Pad Image for Outpainting”节点,可以在创建适当的蒙版时自动填充图像以进行外画。在此示例中,此图像将被外画:

使用 v2 修复模型和“Pad Image for Outpainting”节点(在 ComfyUI 中加载它以查看工作流程):

这些是演示如何使用 Loras 的示例。所有 LoRA 类型:Lycoris、loha、lokr、locon 等……都以这种方式使用。

您可以在ComfyUI中加载这些图像以获得完整的工作流程。

Loras 是在主 MODEL 和 CLIP 模型之上应用的补丁,因此要使用它们,请将它们放在 models/loras 目录中,然后像这样使用 LoraLoader 节点:

您可以通过链接多个 LoraLoader 节点来应用多个 Loras,如下所示:

您可以在ComfyUI中加载这些图像以获得完整的工作流程。

超网络是在主模型上应用的补丁,因此要使用它们,请将它们放在 models/hypernetworks 目录中,然后像这样使用超网络加载器节点:

您可以通过按顺序链接多个超网络加载器节点来应用多个超网络。

这是如何使用文本反转/嵌入的示例。

要使用嵌入,请将文件放入 models/embeddings 文件夹中,然后在提示中使用它,就像我在上一张图片中使用 SDA768.pt 嵌入一样。

请注意,您可以省略文件扩展名,因此这两个是等效的:

embedding:SDA768.pt

embedding:SDA768

您还可以像提示中的常规单词一样设置嵌入的强度:

(embedding:SDA768:1.2)

嵌入基本上是自定义单词,因此将它们放在文本提示中的位置很重要。

例如如果你有一只猫的嵌入:

red embedding:cat

这可能会给你一只红猫。

以下是如何使用 ESRGAN 等高级模型的示例。将它们放在 models/upscale_models 文件夹中,然后使用 UpscaleModelLoader 节点加载它们,并使用 ImageUpscaleWithModel 节点使用它们。

以下是一个例子:

您可以在ComfyUI中加载此图像以获取工作流程。

如果你正在寻找高档模型,你可以在OpenModelDB上找到一些

这些是演示 ConditioningSetArea 节点的示例。您可以在ComfyUI中加载这些图像以获取完整的工作流程。

使用 Anything-V3 进行区域合成 + 使用 AbyssOrangeMix2_hard 进行第二遍

这张图片包含 4 个不同的区域:夜晚、傍晚、白天、早晨

ComfyUI 中的工作流程如下:

该图像包含与上一个图像相同的区域,但顺序相反。

通过添加另一个区域提示将主题添加到图像的底部中心。

通过区域构图提高图像的一致性

稳定扩散在生成分辨率接近 512x512 的方形图像时,可以创建最一致的图像。但是,如果我们想生成宽高比为 16:9 的图像,该怎么办?让我们生成一张坐着的主体的 16:9 图像。如果以正常方式生成,成功率会很低,因为四肢会不自然地延伸到图像上,并存在其他一致性问题。

通过使用区域构图并以方形区域作为主体,一致性将更高,并且由于它与图像的其余部分同时生成,因此整体图像的一致性将非常出色。

此工作流程使用 Anything-V3,这是一个 2 遍工作流程,其中第一遍使用区域合成来对图像左侧的主体进行合成。第二遍的原因只是为了提高分辨率,如果您对 1280x704 图像满意,则可以跳过第二遍。

在图像右侧添加一个红头发的主体,并带有区域提示。

第一遍输出(1280x704):

第二遍输出(1920x1088):

第二遍输出图像说明了稳定扩散的行为之一。第二遍没有区域提示。您会注意到,对象 1 的头发是金色,带有粉红色高光,而对象 2 的头发是粉红色,而不是红色,这与第一遍输出中的情况不同。这是因为稳定扩散试图使整体图像与自身保持一致,而这样做的副作用之一是将头发颜色融合在一起。

您可以在ComfyUI中加载这些图像以获得完整的工作流程。

以下是噪声潜在合成的示例。噪声潜在合成是指在图像完全去噪之前,将潜在合成在一起,同时仍然有噪声。由于姿势和主体等一般形状在第一个采样步骤中被去噪,这让我们能够将具有特定姿势的主体定位在图像上的任何位置,同时保持高度的一致性。

这是一个例子。此示例包含 4 张合成在一起的图像。1 张背景图像和 3 张主体图像。总共 16 步。潜像采样分为 4 步,每步使用不同的提示。背景为 1920x1088,主体为 384x768。经过这 4 步后,图像仍然非常嘈杂。然后将主体合成(粘贴)到背景上,并应用一些羽化效果。然后在此合成图像上运行其余采样步骤。

这些示例是使用 WD1.5 beta 3 幻觉模型完成的。

随着主体位置的改变:

您可以看到,由不同的嘈杂潜像合成的主体实际上相互交互,因为我在提示中加入了“牵手”。您还会注意到背景有多么一致,这表明这种方法有多么强大。

该技术有一些局限性,例如它无法控制主体的细节,例如眼睛的颜色,但它似乎对于主体的位置、姿势和一般颜色非常有效。

请注意,在这些示例中,原始图像直接传递到 ControlNet/T2I 适配器。

如果您想要获得良好的结果,每个 ControlNet/T2I 适配器都需要将传递给它的图像设置为特定格式,例如深度图、精明图等,具体取决于特定模型。

ControlNetApply 节点不会将常规图像转换为深度图、精明图等。您必须单独执行此操作,或使用节点对图像进行预处理,您可以在此处找到:此处

您可以在此处找到最新的 controlnet 模型文件:原始版本或较小的 fp16 safetensors 版本

对于 SDXL,stable.ai 已发布 Control Loras,您可以在这里(排名 256)或这里(排名 128)找到。它们的使用方式与常规 ControlNet 模型文件完全相同(将它们放在同一目录中)。

ControlNet 模型文件位于 ComfyUI/models/controlnet 目录中。

涂鸦控制网

这是一个如何使用控制网的简单示例,此示例使用 scribble 控制网和 AnythingV3 模型。您可以在ComfyUI中加载此图像以获取完整的工作流程。

这是我在此工作流程中使用的输入图像:

T2I 适配器与 ControlNets

T2I 适配器比 ControlNets 效率高得多,因此我强烈推荐它们。ControlNets 会显著降低生成速度,而 T2I 适配器对生成速度几乎没有任何负面影响。

在 ControlNets 中,ControlNet 模型每次迭代运行一次。对于 T2I-Adapter,该模型总共运行一次。

T2I-Adapters 的使用方式与 ComfyUI 中的 ControlNets 相同:使用 ControlNetLoader 节点。

这是本示例源中将使用的输入图像:

深度 T2I 适配器的使用方法如下:

以下是深度控制网的使用方法。请注意,此示例使用 DiffControlNetLoader 节点,因为所使用的控制网是差异控制网。差异控制网需要正确加载模型的权重。DiffControlNetLoader 节点还可用于加载常规控制网模型。加载常规控制网模型时,其行为与 ControlNetLoader 节点相同。

您可以在ComfyUI中加载这些图像以获得完整的工作流程。

位姿控制网

这是本示例中将使用的输入图像:

下面是一个示例,第一次使用带有控制网的 AnythingV3,第二次使用不带控制网的 AOM3A3(深渊橙色混合 3)并使用它们的 VAE。

您可以在ComfyUI中加载此图像以获取完整的工作流程。

混合控制网

可以像这样应用多个 ControlNet 和 T2I 适配器并产生有趣的结果:

您可以在ComfyUI中加载此图像以获取完整的工作流程。

输入图像: